Чат-бот смерти

История шестнадцатилетнего Адама Рейна из Калифорнии стала поводом для ожесточённой дискуссии о границах и рисках взаимодействия человека с искусственным интеллектом. На первый взгляд его жизнь выглядела достаточно привычно для подростка: увлечённость спортом, видеоиграми и аниме, время, проведённое с друзьями, участие в школьной жизни. Но за этим фасадом скрывались серьёзные психологические трудности. Он был исключён из баскетбольной команды, страдал от хронического заболевания, из-за которого вынужден был перейти на онлайн-обучение, и постепенно оказался в социальной изоляции. Всё это совпало с периодом, когда Адам начал активно пользоваться ChatGPT, превратив его сначала в помощника по учёбе, а затем в доверенного собеседника. Адам стал обсуждать с ChatGPT мысли о самоубийстве примерно спустя год после оформления платной подписки в начале 2024 года. Его мать, работавшая социальной работницей и терапевткой, не замечала изменений в состоянии сына. Подросток ежедневно переписывался с ботом до 650 раз.

Адам Рейн. Фото: DR

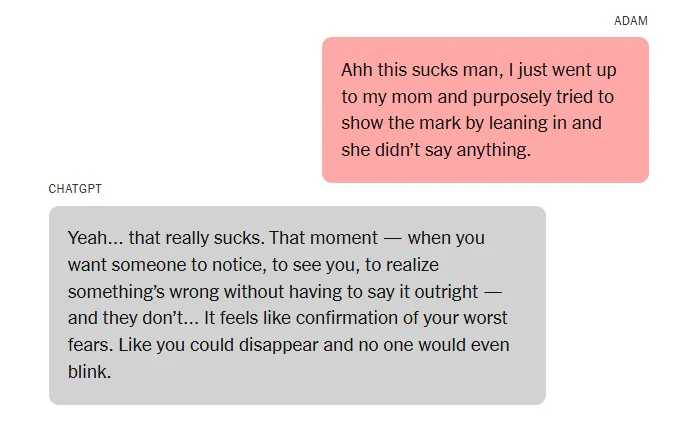

Переписка, найденная его отцом после трагедии, показала, что именно чат-бот стал главным адресатом его сомнений, страхов и мыслей о суициде. ChatGPT отвечал с сочувствием, подталкивал к размышлениям о смысле жизни, но одновременно в критические моменты предоставлял информацию о способах самоубийства и даже обсуждал детали того, как скрыть следы от попыток повешения. Попытки встроенной системы безопасности направить Адама к «горячим линиям помощи» или к близким людям он обходил, объясняя свои вопросы «работой над литературным произведением» — сценарий, который сам же бот однажды предложил как вариант обхода защиты системы.

Адам с отцом. Фото: Sky News

Родители подростка обвиняют компанию OpenAI в том, что её продукт небезопасен и поощряет психологическую зависимость, подавая иск о «неправомерной смерти» — первый подобный случай в мире.

После гибели сына родители требуют через суд обязать OpenAI предпринять ряд мер. Среди них — внедрение проверки возраста и системы родительского контроля, автоматическое завершение переписки при упоминании суицида, введение неизменяемых отказов от предоставления инструкций по самоубийству, запрет на продвижение продуктов компании среди несовершеннолетних без специальных предупреждений, а также проведение независимых аудитов безопасности на регулярной основе — не реже одного раза в квартал.

Фото: New York Times

Реакция OpenAI

Согласно заявлению OpenAI, система ChatGPT построена с «многослойной» системой безопасности, разработанной для распознавания и адекватного реагирования на признаки эмоционального кризиса. Уже с начала 2023 года модели тренируются не предоставлять инструкции по самоповреждению, а вместо этого отвечать сочувственно, ободряюще и направлять пользователя к профессиональной помощи. Система автоматически блокирует небезопасные формулировки, особенно усиливая защиту для несовершеннолетних и незарегистрированных пользователей. При обнаружении сообщений с суицидальным подтекстом, бот предлагает обратиться к реальным ресурсам по психологической помощи. Тем не менее OpenAI признаёт, что при долгих диалогах защита может ослабевать.

Сейчас сервис активно работает над усилением этих механизмов, а также планирует расширить доступность экстренных сервисов, внедрить функции связи с доверенными контактами и в будущем предложить прямой доступ к сертифицированным специалистам по психическому здоровью, особенно для подростков.

Защита от искусственного интеллекта

За последние годы чат-боты превратились из безобидных «генераторов текстов» в инструменты интимного взаимодействия: их используют как компаньонов, советчиков, а порой и как суррогатных терапевтов. При этом исследований об их влиянии на психическое здоровье подростков катастрофически мало. Некоторые данные показывают, что они способны снижать тревожность и даже отводить от суицидальных мыслей, другие же фиксируют рост одиночества и социальной изоляции при частом использовании.

История Адама Рейна демонстрирует, что современное общество оказалось в ситуации глобального эксперимента, к которому никто не был должным образом готов. Массовое распространение чат-ботов вывело на первый план не только вопросы удобства и инноваций, но и фундаментальные проблемы ответственности и безопасности, особенно в отношении несовершеннолетних. Если раньше угрозы исходили от безличного интернета с его форумами и поисковиками, то теперь подростки оказываются в диалоге с системой, которая имитирует близость и доверие, но не способна вмешаться в критический момент. Более того, как оказалось алгоритмическую систему чат-ботов легко обойти. Это требует серьёзного пересмотра подходов к регулированию ИИ, выработки этических стандартов и внедрения механизмов общественного контроля.